QEP

Quantization Error Propagation: Revisiting Layer-Wise Post-Training Quantization阅读笔记

motivation

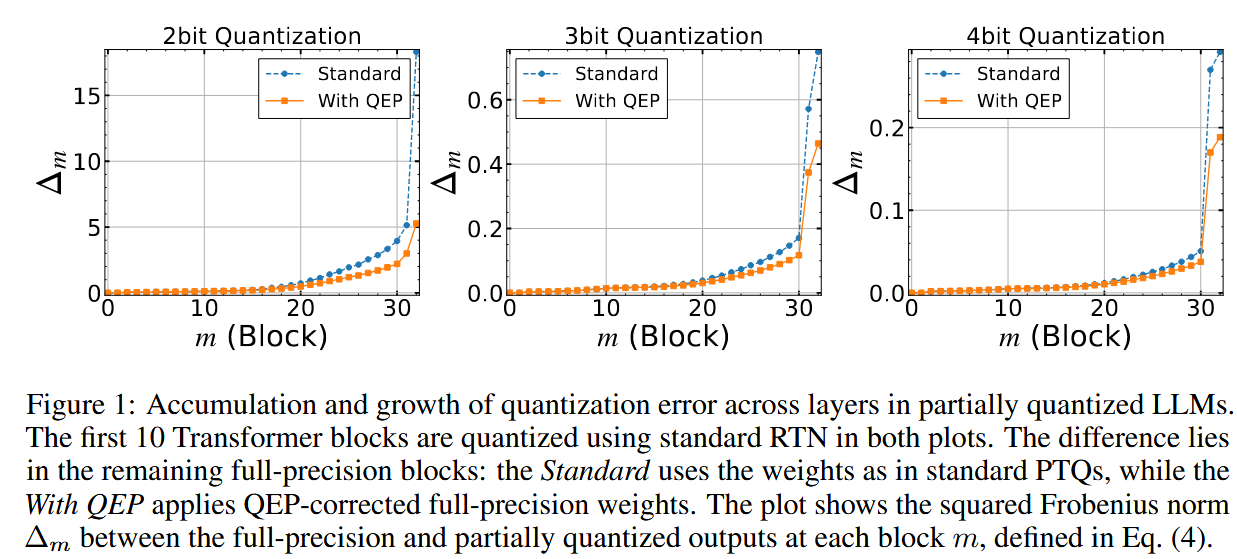

现有量化方法多采用逐层量化的方法,然而量化误差会随着前向传播逐渐传递到更深的层。

尽管图中

带

创新点:考虑量化误差传播的量化方法

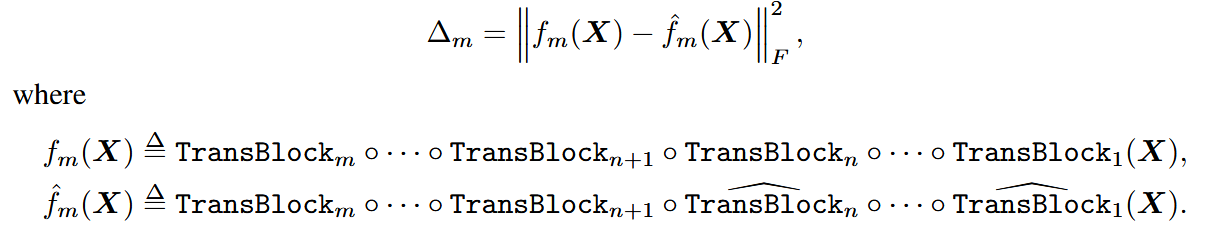

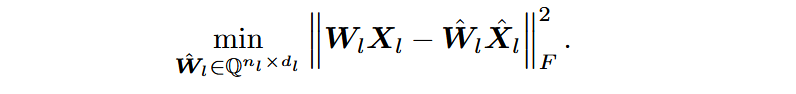

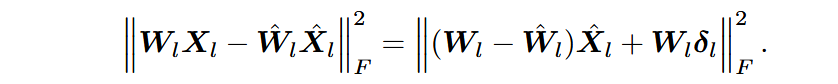

将量化目标重定义对齐每层在前层已经全量化前后的输出误差,形式化表示:

记激活的量化误差为

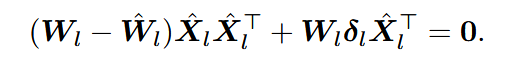

为使其最小,当优化目标梯度为0时候,可得:

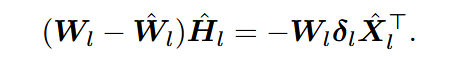

引入经验Hessian矩阵

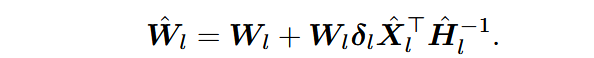

当Hessian矩阵可逆时,均在右侧乘上

然而,真实的经验Hessian矩阵可能是病态的或者是奇异矩阵,会造成数值稳定性上的问题,因此沿用GPTQ的damping策略,给矩阵对角线上的每个元素都加上原本对角线元素的绝对值,使其变成正定的可逆矩阵。

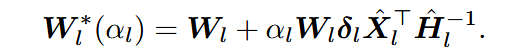

同时为了防止过拟合和过高的计算代价(计算经验Hessian矩阵),为原本的闭式解加上缩放系数

主要还是针对MLP中一些维度比较大的层,直接将其

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 由本自性清净故,令诸爱染悉无垢!