Dobi-SVD

Dobi-SVD: Differentiable SVD for LLM Compression and Some New Perspectives阅读笔记

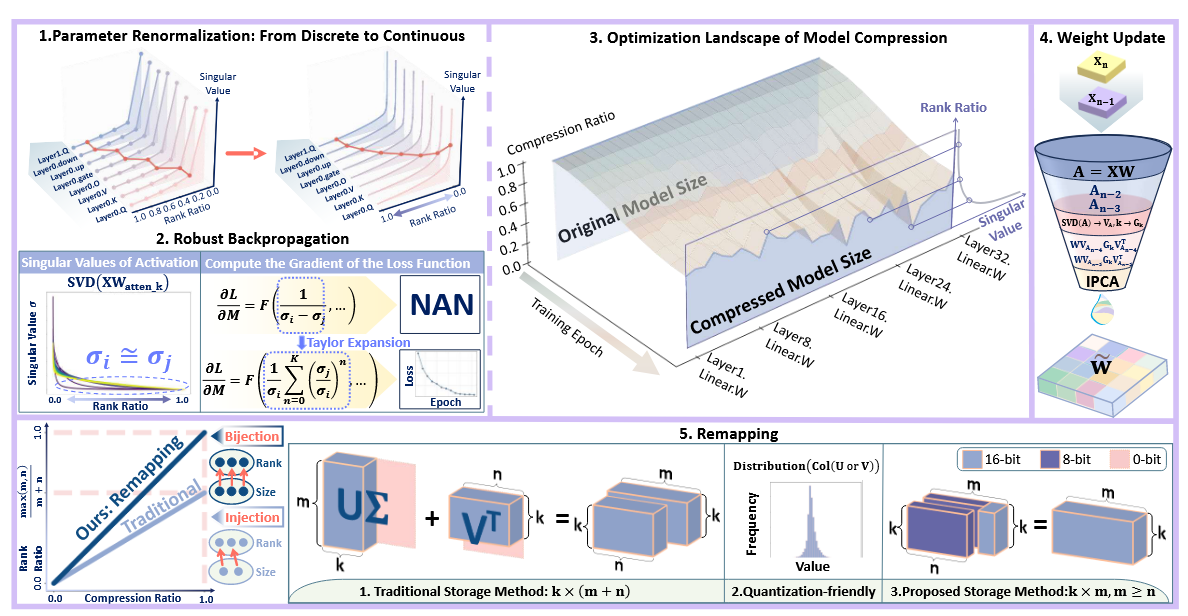

motivation

认为分解激活(这里的激活指的不是输入

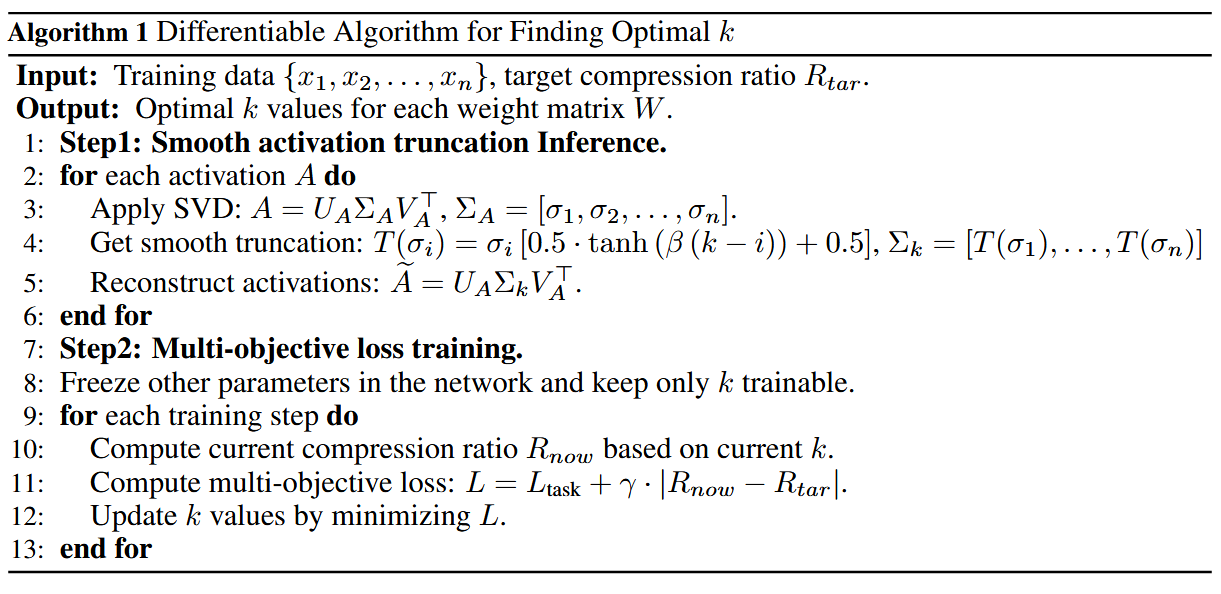

创新点1:逐层自动化目标秩判定

每个模型有L层,每一层有M层,假设每层对应的激活有n个奇异值,则可选择的截断(舍弃top k外的奇异值)位置有

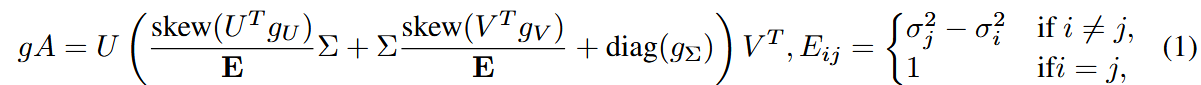

记SVD分解后的激活为

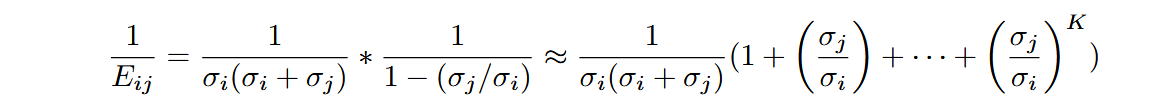

当

为防止梯度爆炸,当

当

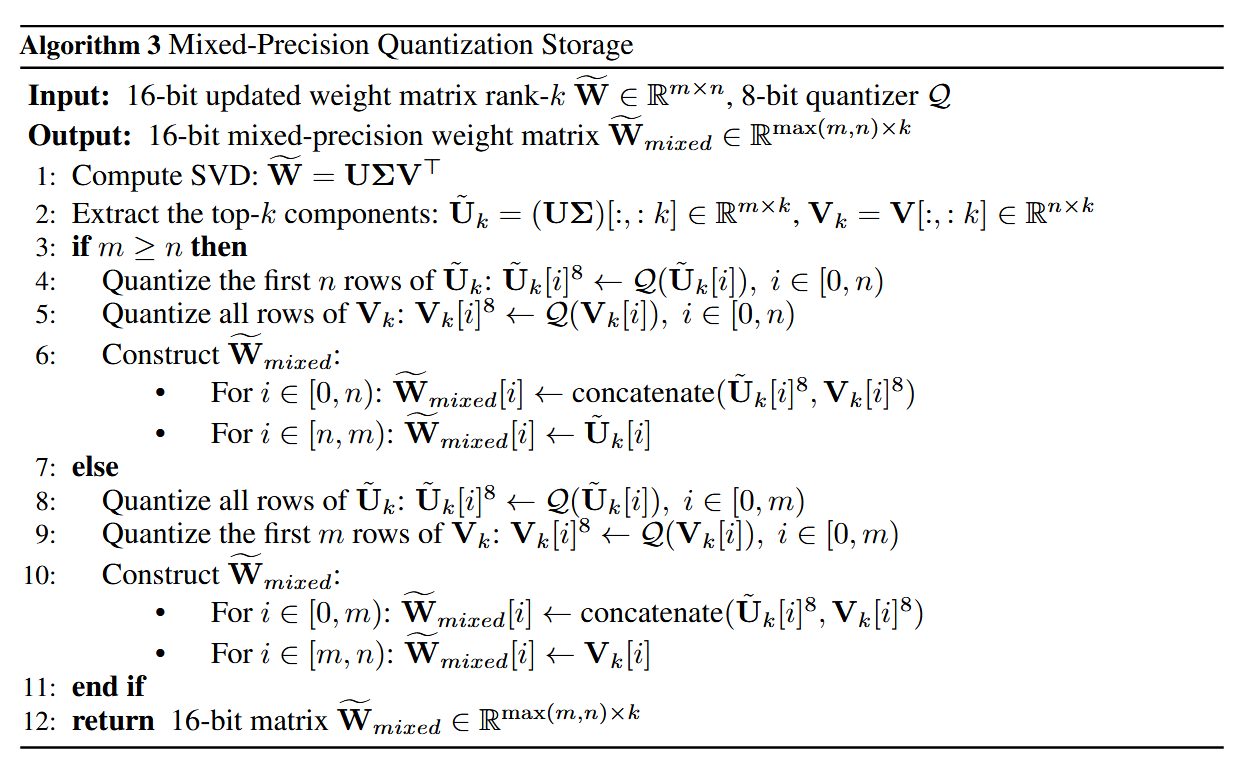

创新点2:权重更新补偿

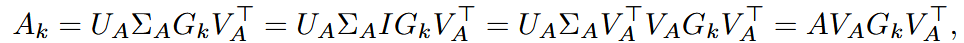

设G为前k的对角元素为1,其他对角元素为0的矩阵,激活分解可看作:

其中激活

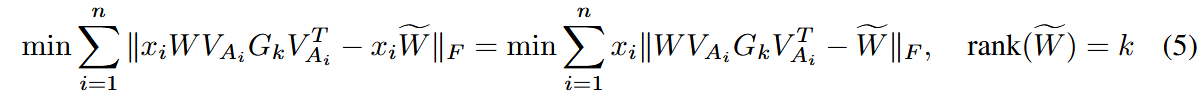

适用增量式主成分分析算法(IPCA)对其进行计算:

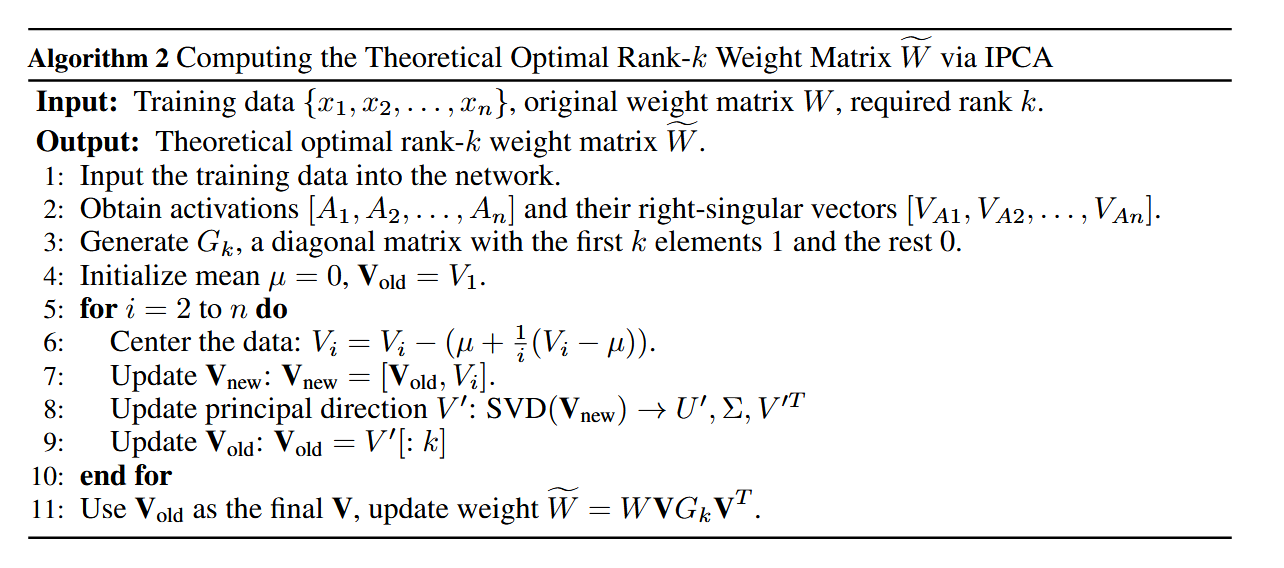

创新点3:混合精度矩阵存储

对于矩阵

不妨令

其它

虽然都是在ICLR 2025上接受的,但这篇实际是在LLM-SVD的基础上进一步做的并和LLM-SVD进行了比较。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 由本自性清净故,令诸爱染悉无垢!