LLM-Streamline

Streamlining Redundant Layers to Compress Large Language Models阅读笔记

motivation

残差结构层输出输出可视作

利用准确率做剪枝后模型的评判指标时,会受部分原始模型答不对,但剪枝后猜对的样本的干扰。

创新点1:基于输入输出相似度的连续层剪枝方法。

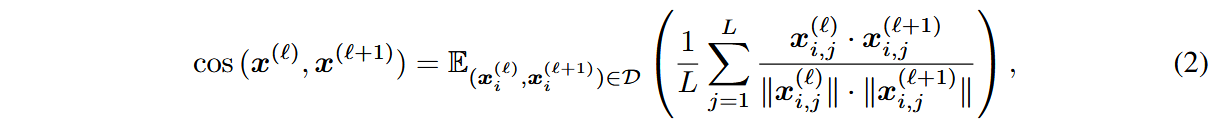

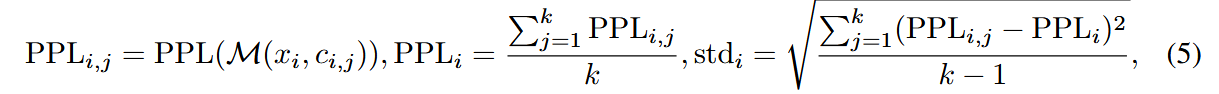

利用余弦相似度去判断输出输出的相似度,越高的相似度代表层越不重要:

其中

之所以选择余弦相似度是因为现有工作表明Pre-Norm架构的模型激活会随着层变深而变大,因此不适宜使用点积和欧氏距离判断。

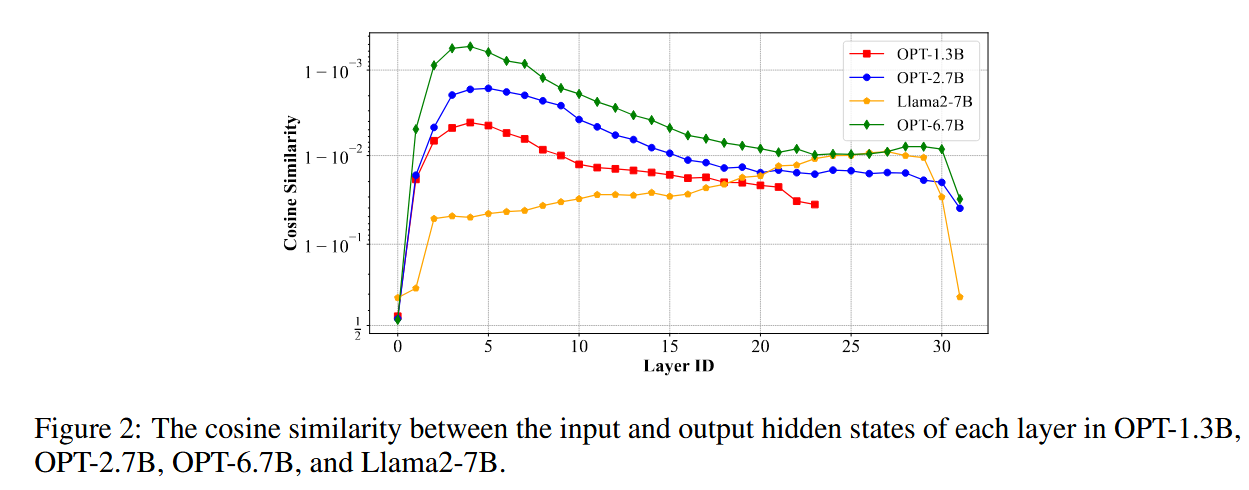

可观察到模型中会出现连续的低重要性层,适宜进行剪枝。

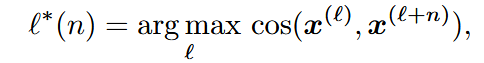

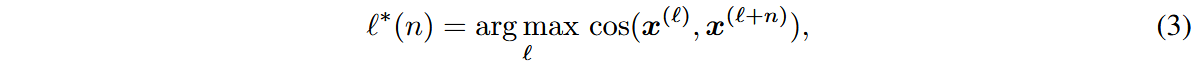

直接选取连续n层余弦相似度最大的层进行剪枝:

创新点2:利用轻量化网络替代被剪枝层

直接使用MSE蒸馏

创新点3:稳定性标准

传统的准确率指标可能会因为模型在某些样本上的随机猜测(比如原模型答错但量化后猜对的情况)而高估其性能,没有考虑到模型对于答案的信心。

定义模型对于问题

标准差越大说明模型对于答案的信心越大。

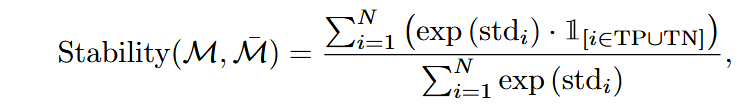

则稳定性指标可表示为:

其中TP表示量化前后模型都答对的样本,TN表示量化前后模型都答错的样本。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 由本自性清净故,令诸爱染悉无垢!